دستور مرگ با الگوریتم: دوران رباتهای قاتل بیش از همیشه به ما نزدیک است؛ قسمت اول+عکس

پیشرفت بشر در حوزهی رباتیک سریع تر و نگران کننده تر از همیشه بهنظر میرسد. پیشرفتی که شاید به ساخت ربات های قاتل منجر شود.

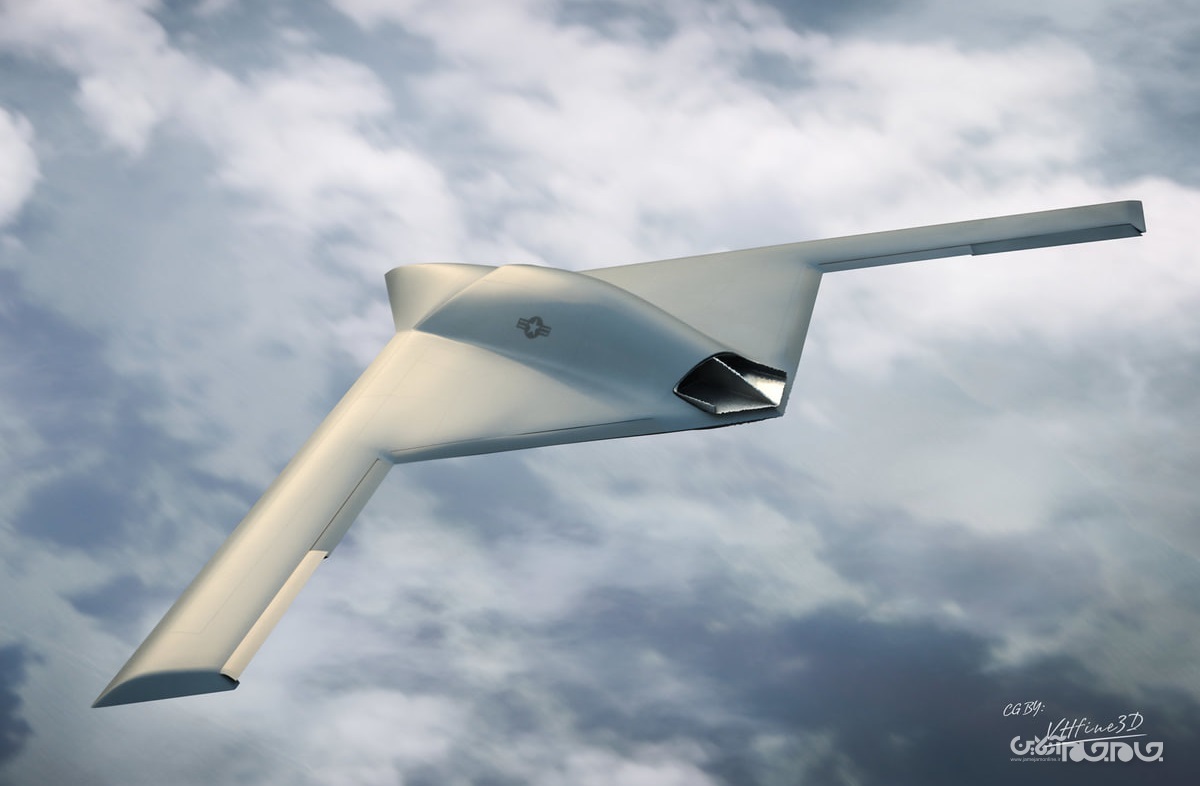

به گزارش جام جم آنلاین به نقل از زومیت، تصور کنید ارتشی بزرگ قصد دارد شهری را در جریان نبرد جنگی تصرف کند. فرماندهان نمیخواهند نیروهای نظامی در نبردهای خانهبهخانه درگیر شوند و تلفات زیادی داشته باشند. آنها ابتدا گروهی از پهپادهای کوچک را با دستورالعملی ساده به منطقه میفرستند: هر فردی که سلاح حمل میکند را بکشید. چند ساعت بعد، شهر برای نفوذ نیروهای انسانی امن خواهد بود.

سناریوی بالا شبیه به صحنهای از یک فیلم علمی تخیلی بهنظر میرسد. شاید باور نکنید که فناوری مورد نیاز برای پیوند دادن داستان بالا به حقیقت، هماکنون در دستان انسانها قرار دارد. ارتشهای متعددی در سرتاسر جهان تلاش میکنند تا این داستان را به واقعیت پیوند دهند.

متخصصان یادگیری ماشین و فناوریهای نظامی اعتقاد دارند ساخت رباتهایی با قابلیت تصمیمگیری بدون دخالت انسان، از لحاظ فناورانه ساده محسوب میشود. رباتهای مورد نظر آنها، میتوانند بدون درگیر کردن انسانها در فرایندهای تصمیمگیری، هدفهای کشتار خود را انتخاب کنند. بهبیاندیگر هیچ فردی از هیچیک از مراحل انتخاب تا کشتن سوژه دخالت نخواهد کرد. با قدرتمندتر شدن فناوریهای تشخیص چهره و الگوریتمهای تصمیمگیری، توسعهی چنین روندی روزبهروز هم آسانتر میشود.

سلاحهایی که در بالا به آنها اشاره کردیم، بهعنوان «سلاحهای مرگبار خودکار» در اسناد نظامی مطرح میشوند. درواقع همان نام «ربات قاتل» را میتوان برای چنین فناوری استفاده کرد. سلاحهای مذکور برخلاف تصور مردم عادی بهصورت رباتهای انساننما نخواهند بود و عموما، پهپاد هستند. درواقع ساختن رباتهای انساننمای مبارز هنوز مراحل دشواری در پیش دارد. بههرحال ساختن پهپادهای مرگبار آسانتر از روندهای کنونی خواهد بود و قطعا محصولاتی ارزانتر هم تولید میشوند.

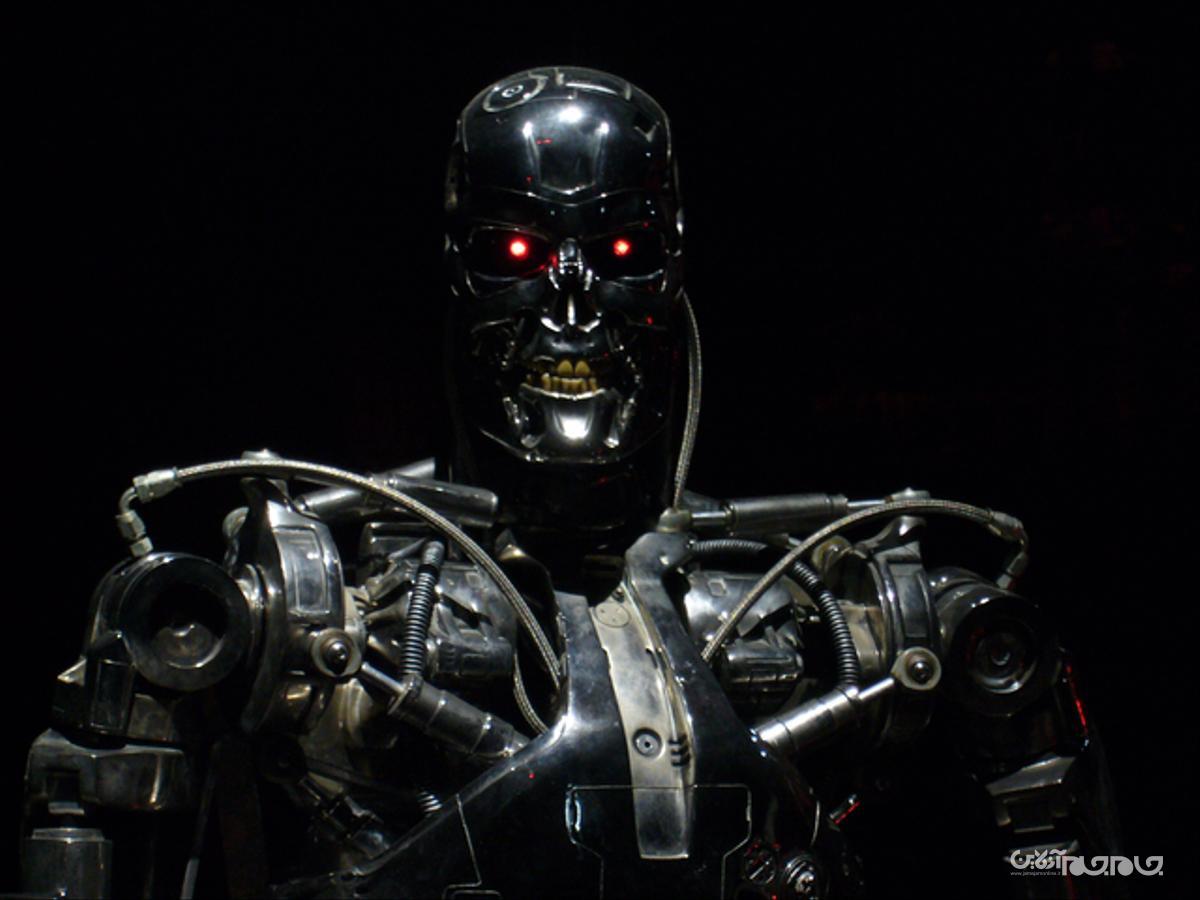

اکنون و با توسعهی فناوری رباتیک، محققان حوزهی هوش مصنوعی و سیاستهای عمومی تلاش میکنند تا جامعه و دولتمردان را از خطرات رباتهای قاتل مطلع کنند. آنها میگویند چنین رباتهایی نهتنها در فیلمهای علمی تخیلی، بلکه در زندگی واقعی نیز ایدهی بدی هستند. هوش مصنوعی قطعا کاربردهایی در کاهش اثرات مرگبار جنگ و آسیبهای آن دارد. منتهی اسلحههای کاملا خودکار میتوانند بحرانهای جدی استراتژیک، فنی و اخلاقی ایجاد کنند. بههمیندلیل دانشمندان و فعالان اجتماعی تلاش میکنند تا سازمان ملل متحد و دولتهای سرتاسر جهان را به ایجاد ممنوعیتهای پیشگیرانه تشویق کنند. آنها امیدوار هستند که رباتهای قاتل را در همان فیلمهای علمی تخیلی نگه دارند.

سناریوی بالا شبیه به صحنهای از یک فیلم علمی تخیلی بهنظر میرسد. شاید باور نکنید که فناوری مورد نیاز برای پیوند دادن داستان بالا به حقیقت، هماکنون در دستان انسانها قرار دارد. ارتشهای متعددی در سرتاسر جهان تلاش میکنند تا این داستان را به واقعیت پیوند دهند.

متخصصان یادگیری ماشین و فناوریهای نظامی اعتقاد دارند ساخت رباتهایی با قابلیت تصمیمگیری بدون دخالت انسان، از لحاظ فناورانه ساده محسوب میشود. رباتهای مورد نظر آنها، میتوانند بدون درگیر کردن انسانها در فرایندهای تصمیمگیری، هدفهای کشتار خود را انتخاب کنند. بهبیاندیگر هیچ فردی از هیچیک از مراحل انتخاب تا کشتن سوژه دخالت نخواهد کرد. با قدرتمندتر شدن فناوریهای تشخیص چهره و الگوریتمهای تصمیمگیری، توسعهی چنین روندی روزبهروز هم آسانتر میشود.

سلاحهایی که در بالا به آنها اشاره کردیم، بهعنوان «سلاحهای مرگبار خودکار» در اسناد نظامی مطرح میشوند. درواقع همان نام «ربات قاتل» را میتوان برای چنین فناوری استفاده کرد. سلاحهای مذکور برخلاف تصور مردم عادی بهصورت رباتهای انساننما نخواهند بود و عموما، پهپاد هستند. درواقع ساختن رباتهای انساننمای مبارز هنوز مراحل دشواری در پیش دارد. بههرحال ساختن پهپادهای مرگبار آسانتر از روندهای کنونی خواهد بود و قطعا محصولاتی ارزانتر هم تولید میشوند.

اکنون و با توسعهی فناوری رباتیک، محققان حوزهی هوش مصنوعی و سیاستهای عمومی تلاش میکنند تا جامعه و دولتمردان را از خطرات رباتهای قاتل مطلع کنند. آنها میگویند چنین رباتهایی نهتنها در فیلمهای علمی تخیلی، بلکه در زندگی واقعی نیز ایدهی بدی هستند. هوش مصنوعی قطعا کاربردهایی در کاهش اثرات مرگبار جنگ و آسیبهای آن دارد. منتهی اسلحههای کاملا خودکار میتوانند بحرانهای جدی استراتژیک، فنی و اخلاقی ایجاد کنند. بههمیندلیل دانشمندان و فعالان اجتماعی تلاش میکنند تا سازمان ملل متحد و دولتهای سرتاسر جهان را به ایجاد ممنوعیتهای پیشگیرانه تشویق کنند. آنها امیدوار هستند که رباتهای قاتل را در همان فیلمهای علمی تخیلی نگه دارند.

رباتهای قاتل چگونه عمل میکنند؟

آمریکاییها و بسیاری کشورهای دیگر هماکنون نیز از پهپادهای نظامی استفاده میکنند. این پهپادها در حال حاضر نیز در آسمان بسیاری از کشورها درحال پرواز هستند. البته در نمونههای کنونی، انسانها تصمیم نهایی را در شلیک آتش به پهپاد ارسال میکنند. سلاحهای مرگبار خودکار (به اختصار با LAWS شناخته میشوند) هنوز بهصورت کامل وجود خارجی ندارند؛ اما فناوری لازم برای جایگزین کردن انسانهای تصمیمگیر با الگوریتم، طراحی شده است.

استوارت راسل استاد علوم کامپیوتر دانشگاه یوسی برکلی و محقق هوش مصنوعی دربارهی سلاحهای خودکار میگوید:

توسعهی سلاحهای خودکار از لحاظ فناورانه آسانتر از خودروهای خودران است. افرادی که در فناوریهای مرتبط کار میکنند، توسعهی چنین سلاحهایی را حداکثر تا دو سال آینده آسان و ممکن میدانند.

سلاحهای خودکار آینده شبیه به فیلم ترمیناتور نخواهند بود. سادهترین نسخههای آنها از سختافزارهای کنونی پهپادهای نظامی بهره میبرند. البته پهپادهای کنونی ویدئوی زندهای از محل درگیری را به مرکز نظامی ارسال میکنند که سرباز مورد نظر، براساس ویدئو دستور شلیک میدهد. درمقابل، سلاحهای خودکار سربازر را از چرخه خارج میکنند و تصمیمگیری توسط الگوریتم انجام میشود.

الگوریتمها را میتوان با فهرستی از اهداف احتمالی تغذیه کرد. آنها با بررسی ویدئوهای خود و پس از اطمینان حداکثری از شناسایی فرد مورد نظر، شلیک را انجام میدهند. بهعلاوه میتوان الگوریتم را با نمونههایی از میدان نبرد آموزش داد. پس از مدتی الگوریتم متوجه میشود که در چه موقعیتهایی احتمال صدور فرمان حمله بیشتر خواهد بود. ماشین مورد نظر در آن موقعیتها بهصورت خودکار دستور حمله را صادر و اجرا میکند. در نمونهای دیگر میتوان دستور سادهای به الگوریتم داد تا با شناسایی بصری، هر فردی را که بدون پوشیدن یونیفرمهای خودی، سلاح حمل کند، هدف قرار دهد.

توبی والش، استاد هوش مصنوعی در دانشگاه نیو ساوث ولز و فعال مبارز علیه توسعهی سلاحهای خودکار مرگبار دربارهی آنها میگوید:

وقتی دربارهی رباتهای قاتل صحبت میکنیم، مردم فیلم ترمیناتور را تصور میکنند. آنها فیلمهای علمی تخیلی را در نظر میگیرند. مردم فکر میکنند این فناوری سالها از ما فاصله دارد. درواقع سلاحهای مرگبار فناوریهای سادهای دارند که نزدیکتر از همیشه به ما هستند. بهعلاوه هماکنون نیز نمونههای اولیهی آنها ساخته میشود.

در سالهای گذشته، هوش مصنوعی با سرعت بالایی رشد کرده است. تشخیص چهره بیش از هیشه دقیق شد و شناسایی اجسام نیز با همان سرعت پیشرفت کرد. فناوریهایی که برای توسعهی سلاحهای مرگبار خودکار، الزامی هستند.

روشهای جدید به سیستمهای هوش مصنوعی امکان انجام کارهایی را میدهند که چند سال پیش غیرممکن بهنظر میرسید. از نوشتن داستان تا طراحی و ساخت چهرههای قلابی امروزه بهراحتی توسط هوش مصنوعی انجام میشود. بهعلاوه فناوری امروز میتواند در بازیهای جنگی آنلاین تصمیمهای استراتژیک کاربردی بگیرد که در توسعهی سلاحهای مرگبار خودکار بسیار کاربردی خواهد بود.

پیشرفتهای بالا ثابت میکنند که توسعهی سلاحهای خودکار مرگبار امروز از غیرممکن به ساده تبدیل شده است. پیشرفتها نیز به این خاطر ایجاد شدند که ما مردم جهان هیچ اجماع یا نظرسنجی را پیرامون صحیح بودن یا نبودن توسعهی آنها انجام ندادهایم.

چرا نیروهای نظامی به ربات نیاز دارند؟

خارج کردن انسانها از چرخه و توسعهی سلاحهایی که بهصورت خودکار تصمیمگیری میکنند، چالشهای اخلاقی خطرناکی بههمراه دارد. همانطور که گفته شد چالشهای استراتژیک هم ایجاد خواهند شد که بعدا به آن میپردازیم. بههرحال اکنون این سؤال مطرح میشود که چرا فرد یا سازمانی باید بهدنبال چنین سلاحهایی باشد؟

از دیدگاه نظامی، برترین مزیت سلاحهای خودکار، فرصتهای جدیدی خواهد بود که با استفاده از آنها ایجاد میشود. در وضعیت کنونی که ارتشها به یک سرباز برای تصمیمگیری دربارهی شلیک یا عدم شلیک نیاز دارند، تعداد پهپادهای در دسترس نیروی نظامی محدود به تعداد سربازان میشود.

پهپادهای کنونی نیاز به ارسال و دریافت داده با مرکز نظامی دارند. همین ارتباط کمی تأخیر در تصمیمگیری و عملکرد سلاح ایجاد میکند. بهعلاوه محل مناسب فعالیت سلاحها هم محدود میشود و بهنوعی آسیبپذیر هم میشوند. چرا که اگر نیروهای دشمن ارتباط را قطع کرده یا تداخلی در آن ایجاد کنند، پهپاد عملا بیفایده میشود.

سلاحهای موسوم به LAWS توانایی ازبینبردن محدودیتهای بالا را دارند. والش در بخش دیگری از صحبت پیرامون سلاحهای خودکار میگوید:

وقتی انسان از روندها خارج شود، شما میتوانید هزاران یا میلیونها سلاح خودکار داشته باشید. بهعلاوه به این تعداد نیروی انسانی نیز نیاز نخواهید داشت. دیگر نباید نگران تداخل در ارتباط باشید که امروزه بهعنوان راهکاری برای مقاله با پهپادهای تحت کنترل انسان استفاده میشود.

والش در ادامه میگوید که کاهش نیروی انسانی مورد نیاز، تنها کاربرد سلاحهای کاملا خودکار نیست. او میگوید رباتها عموما عملکردهای اخلاقی بهتری دارند. به بیان دیگر انسانها برخی اوقات جنایات جنگی مرتکب میشوند و از روی عمد، غیرنظامیها را هدف قرار میدهند. بهعلاوه انسانها احساس خستگی، استرس و گیجی را تجربه میکنند. انسانها درصد اشتباه بالایی دارند، درحالیکه رباتها تنها از کد دستوری پیروی میکنند.

رنجر پائول شار متخصص سابق دفاع در پنتاگون و ارتش آمریکا ایدهی رباتهای خودکار را در کتاب سال ۲۰۱۸ خود بهنام Army of None مطرح میکند. او در بخشی از کتاب میگوید:

ماشینها برخلاف سربازهای انسانی هیچگاه عصبانی نمیشوند و بهدنبال انتقامجویی نیستند. اکنون بهراحتی میتوان عملکرد مناسب سلاحهای آینده را متصور شد. آنها دیگر در تشخیص بین یک ابزار کشاورزی با اسلحه، اشتباه نمیکنند.

شار در پاین میگوید که استدلالهایش دربارهی سلاحها مشکلات اخلاقی جدی دارد. او در بخشی از کتاب میگوید: «آنچه که صحیح تصور میکنیم، همیشه با آنچه که قانونی است برابر نخواهد بود». او داستانی را از جنگ افعانستان و رویارویی تیمش با طالبان نقل میکند. در داستان او، طالبان از کودکی ۶ ساله استفاده کرده بود تا در ظاهر چوپانی گلهی گوسفندان، آمار موقعیت نیروهای آمریکایی را گزارش کند.

کهنهسرباز ارتش آمریکا میگوید: «قانون جنگ برای مبارزان محدودیت سنی مشخص نمیکند». طبق قوانین جنگ، یک مبارز طالبان (هرچند خردسال) در داستان بالا در عملیاتی نظامی علیه نیروهای آمریکای حضور داشت و کشتن او، مجاز تلقی میشد. البته طبق ادعای شار، سربازها به کودک شلیک نکردند، اما رباتی که طبق قوانین جنگی الگوریتمنویسی شود، چنین انتخابی نخواهد کرد. بههرحال شار پارادوکسی را مطرح میکند که در آن، ربات و انسان عملکردهایی متناقض با هم دارند. برخی اوقات انسانها عملکردهایی خلاف قوانین جنگی دارند و در مواقعی دیگر، بهخاطر کدهای انسانی و احساسی، تصمیمات بهتری میگیرند. رباتها هیچگاه چنین تصمیمگیریهایی نخواهند داشت.

امیلیا یاورسکی بنیانگذار سازمان «دانشمندان دربرابر سلاحهای غیر انسانی (Scientists Against Inhumane Weapons)» اعتقاد دارد راههای بهتری برای استفاده از رباتها در جریان جنگها وجود دارد. او میگوید میتوان از فناوری در جهت جلوگیری از جرایم جنگی استفاده کرد:

انسانها و ماشینها اشتباهات متفاوتی مرتکب میشوند. اگر آنها را با هم بهکار بگیریم، میتوان از ارتکاب هر دو نوع اشتباه جلوگیری کرد. چنین رویکردی را امروز در پزشکی میبینیم. الگوریتمهای شناسایی بیماری یک نوع اشتباه انجام میدهند و پزشکان اشتباه دیگری مرتکب میشوند.

در نتیجهی پیشنهاد یاورسکی شاید بتوان سلاحهایی را طراحی کرد که قوانین جنگ را بدانند. سپس میتوان از آنها انتظار داشت که با هر دستور مخالف قوانین، مقابله کنند. بهعلاوه آنها نباید بدون نظارت نیروی انسانی، اجازهی شلیک داشته باشند. سازمان دانشمندان دربرابر سلاحهای غیر انسانی و جنبشهای مشابه در سرتاسر جهان، مخالفتی با چنین رویکردی از سوی فناوری ندارند. آنها میگویند که وجود یک انسان در چرخهی تصمیمگیری و عملکرد سلاحها باید بهعنوان قانونی بینالمللی و بخشی اساسی در توسعهی سلاحها در نظر گرفته شود.

اگر مسیر صحیحی در توسعهی سلاحهای رباتیک طی شود، میتوان به آیندهای بهتر امیدوار بود. درنتیجه رباتهایی را شاهد خواهیم بود که حفاظهایی خودکار علیه اشتباههای جنگی ایجاد میکنند. بهعلاوه انسانها در روند تصمیمگیری آنها حضور دارند تا از صحیح بودن تصمیمهای خودکار مطمئن شوند. درنهایت تحلیلگرها نگران هستند که حرکت کنونی بهسمت خودکارسازی کامل حرکت میکند. دنیایی که در آن رباتها بدون ورودی انسانی، دستور کشتن قربانیان را صادر و اجرا میکنند.

تازه ها

پیشنهاد سردبیر

در یادداشتی اختصاصی برای جام جم آنلاین مطرح شد

جنبش مردمی سوریه

در یادداشتی اختصاصی برای جام جم آنلاین مطرح شد

زمان دیپلماسی برای حمایت از مقاومت

گفت و گو